ENTENDA QUE MEDIÇÕES SÃO IMPERFEITAS

Uma medição perfeita, isto é, sem erros, só pode existir se um sistema de medição perfeito existir e a grandeza sob medição, denominada mensurando, tiver um valor único, perfeitamente definido e estável. Apenas neste caso hipotético ideal, o resultado de uma medição pode ser expresso por um número e uma unidade de medição apenas. Porém, no mundo real, sabe-se que não existem sistemas de medição perfeitos e utópicos.

Aspectos tecnológicos forçam que qualquer sistema de medição construído resulte imperfeito: suas dimensões, forma geométrica, material, propriedades elétricas, ópticas, pneumáticas, etc., não correspondem exatamente à ideal e plenamente fixada.

As leis e princípios físicos que regem o funcionamento de alguns sistemas de medição, como se vê, nem sempre são perfeitamente lineares como uma análise simplista poderia supor.

Por isso, ao realizar medições, é importante ter em mente que estas não são completamente precisas, pois estão associadas a incertezas. Por isso, para analisar os dados de medição, precisamos entender a natureza dos erros associados às medidas.

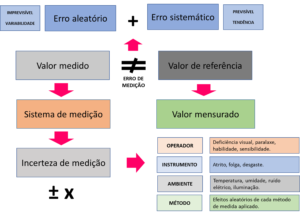

ERROS DE MEDIÇÃO

Por ser um conceito idealizado, os erros de medição não podem ser conhecidos exatamente. Por esta razão, o que se faz é estimar o erro de medição através da diferença entre o valor medido de uma grandeza e um valor de referência convencionado.

Os erros podem ser aleatórios ou sistemáticos conforme quadro a seguir:

| ERRO ALEATÓRIO | ERRO SISTEMÁTICO |

|

|

Estes erros podem derivar de uma série de fatores como perícia e competência do operador, das características do instrumento de medição, das condições ambientais onde a medição é realizada, do método de medição em si ou por outras causas e motivos.

Se o erro de medição fosse perfeitamente conhecido, ele poderia ser corrigido e sua influência completamente anulada da medição.

Contudo, a componente sistemática do erro de medição pode ser suficientemente bem estimada, porém não a componente aleatória. Consequentemente, não é possível compensar totalmente o erro.

O conhecimento aproximado do erro sistemático e a caracterização da parcela aleatória é sempre desejável, pois isto torna possível sua correção parcial e a delimitação da faixa de incerteza ainda presente no resultado de uma medição.

Os erros sistemáticos e aleatórios são muitas vezes influenciados por fontes de erros que estão ligadas basicamente ao operador e ao método, cujos principais tipos de erros são:

- Grosseiro: Causados por falta de atenção do operador, por exemplo, anotando um número errado ou trocando uma vírgula de posição. Pode ser causado também pelo mau funcionamento do instrumento, como um dígito falhando ou um ponteiro enroscando. Em medidas elétricas ou de temperatura, uma simples inversão de polaridade já causa esse tipo de erro;

- Acidental: Pode ocorrer, por exemplo, durante a medição do consumo de energia elétrica de um aparelho quando há uma queda na tensão de alimentação sem que seja percebida pelo operador, afetando o resultado final. Durante a pesagem de um produto, alguém bate na bancada e trepida a balança. Quando numa titulação, o operador se atrapalha para fechar a bureta;

- De inserção: Quando a introdução do instrumento de medição interfere na medida, por exemplo: quando introduzimos um termômetro de vidro em um recipiente com um líquido e a temperatura do termômetro poderá interferir na temperatura do líquido. Isso pode ocorrer também em medições elétricas, ou até mesmo quando medimos alguma peça com um paquímetro ou micrômetro e causamos deformação na peça;

- Paralaxe: Esse erro ocorre em instrumentos analógicos, devido ao ângulo de visão do operador em relação à escala do instrumento;

- De zeragen: Alguns instrumentos de medição apresentam ajustes de zero. Caso essa zeragem não esteja correta acarretará um erro de medição.

INCERTEZA DE MEDIÇÃO

A palavra “incerteza” significa dúvida, e assim, no sentido mais amplo, “incerteza de medição” significa dúvida acerca da validade do resultado de uma medição. É o valor “X” que pode variar para cima ou para baixo, portanto, ± X.

Devido à falta de palavras diferentes para esse conceito geral de incerteza e para as grandezas específicas que proporcionam medidas quantitativas do conceito, como, por exemplo, o desvio-padrão, é necessário utilizar a palavra “incerteza” nestas duas acepções diferentes.

A incerteza de medição inclui componentes provenientes de efeitos sistemáticos, tais como componentes associadas a correções e a valores atribuídos a padrões, assim como a incerteza definicional.

A incerteza de medição geralmente engloba muitas componentes. Alguns podem ser estimados por uma avaliação do tipo A da incerteza de medição que são obtidos a partir da distribuição estatística dos valores provenientes de séries de medições e podem ser caracterizados por desvios-padrão.

As outras componentes podem ser estimadas por uma avaliação do tipo B da incerteza de medição, que podem também ser caracterizadas por desvios-padrão estimados a partir de funções de densidade de probabilidade baseadas na experiência ou em outras informações.

Geralmente para um dado conjunto de informações, subentende-se que a incerteza de medição está associada a um determinado valor atribuído ao mensurando, portanto, uma modificação deste valor resulta numa modificação da incerteza associada.

APLICAÇÃO PRÁTICA NA SEGURANÇA DOS ALIMENTOS

Suponha que num processo de esterilização você precise de uma temperatura de 130°C para atingir o F0 que permita alcançar a redução de uma determinada carga microbiana a níveis aceitáveis. Porém, há uma incerteza de medição de ± 1°C, assim quando você mede, pode ser que seja 130°C, mas também pode ser 129°C ou 131°C. Você não sabe, há uma incerteza!

O 130°C seria ótimo, o 131°C não seria um problema, mas o 129°C seria insuficiente para a redução logarítmica da carga microbiológica necessária que garantiria a segurança ao produto, ou seja, insuficiente para atingir a letalidade de um microrganismos de referência, tema tratado no artigo “Considerações sobre o efeito térmico na segurança dos alimentos“.

Por isso, se a temperatura mínima necessária é 130°C e há uma incerteza de medição de ± 1°C, indica-se trabalhar com no mínimo 131°C, com isso, na pior hipótese, a temperatura estará nos desejáveis 130°C.

Por isso, quando possível, devido a limitações ocasionadas pela temperatura poderem afetar os produtos em suas características organolépticas, acrescenta-se mais alguns graus como margem, trabalhando-se com limites de segurança e não apenas com os críticos.

Se houver erros de medição conhecidos, fatores de compensação podem também ser acrescidos.

Com isso, garantiríamos a letalidade térmica necessária compensando a dúvida gerada pela incerteza de medição e pelo erro.

Leia também:

- 6 Passos Críticos para um Programa de Calibração na indústria de alimentos.

- 5 Cuidados com instrumentos de medição

- Qual a diferença entre calibrar, verificar e ajustar?

- Critérios para escolha de instrumentos de medição

Se você gostou deste artigo, deixe seu comentário e compartilhe com os amigos!

5 min leituraENTENDA QUE MEDIÇÕES SÃO IMPERFEITAS Uma medição perfeita, isto é, sem erros, só pode existir se um sistema de medição perfeito existir e a grandeza sob medição, denominada mensurando, tiver […]